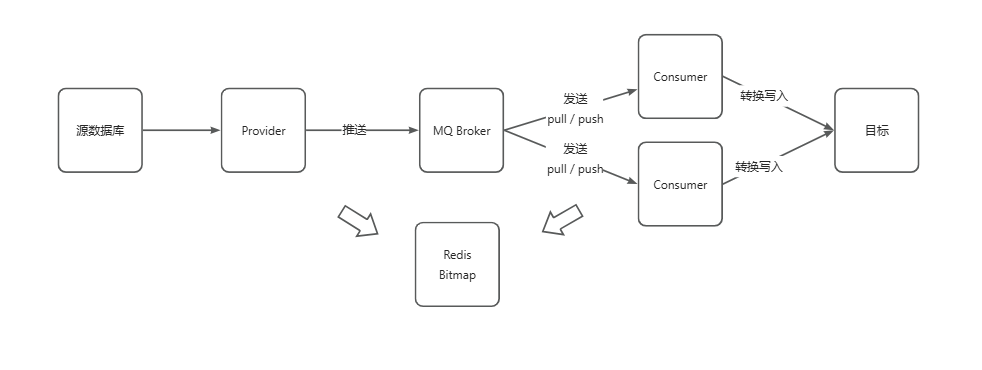

海量数据迁移解决方案

一、海量数据离线迁移会遇到哪些问题

海量数据迁移是一项复杂且具有挑战性的任务,它在企业信息化建设、云服务迁移、数据中心整合等场景中极为常见。这一过程中,组织和技术团队会面临多种挑战,以及需要采取相应的策略来确保数据的完整、安全和高效迁移。以下是一些主要挑战及解决方案:

- 数据量巨大与迁移速度

- 数据一致性与完整性

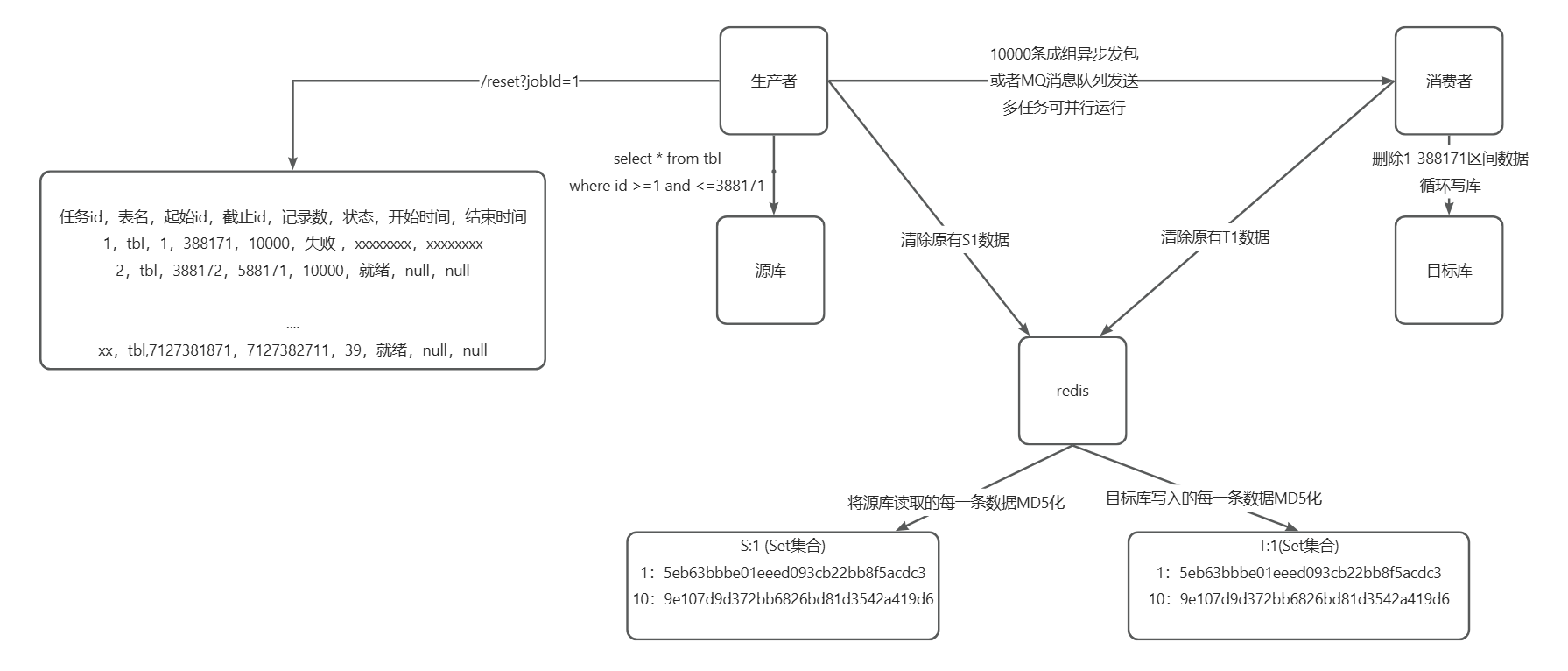

- 业务中断风险,要支持回滚

- 系统兼容性与格式转换

二、BitMap亿级数据迁移最终一致性

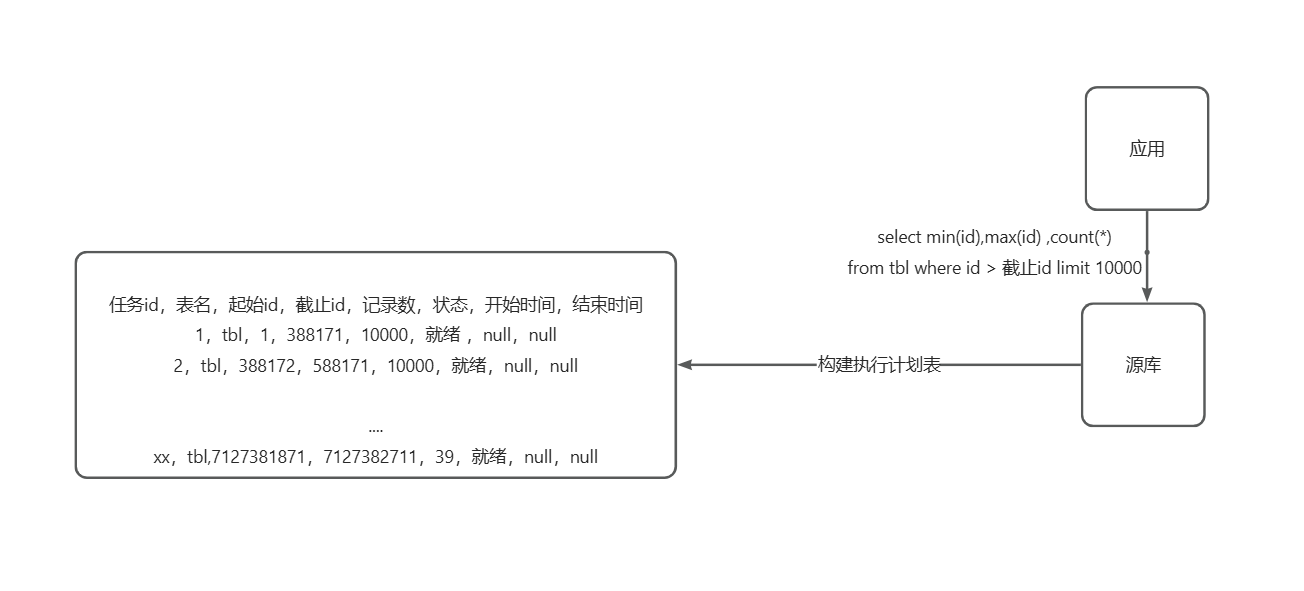

1.生成执行计划

50亿数据,上下游在Redis按执行计划创建多个Redis Key

| id区间 | source-key |

target-key |

|---|---|---|

| 0-1亿(不含) | source-表名-s0e1 | target-表名-s0e1 |

| 1亿-2亿(不含) | source-表名-s1e2 | target-表名-s1e2 |

| … | ||

| 49亿-50亿(不含) | source-表名-s49e50 | target-表名-s49e50 |

任务可串行执行,也可并行执行,具体看内存和处理速度

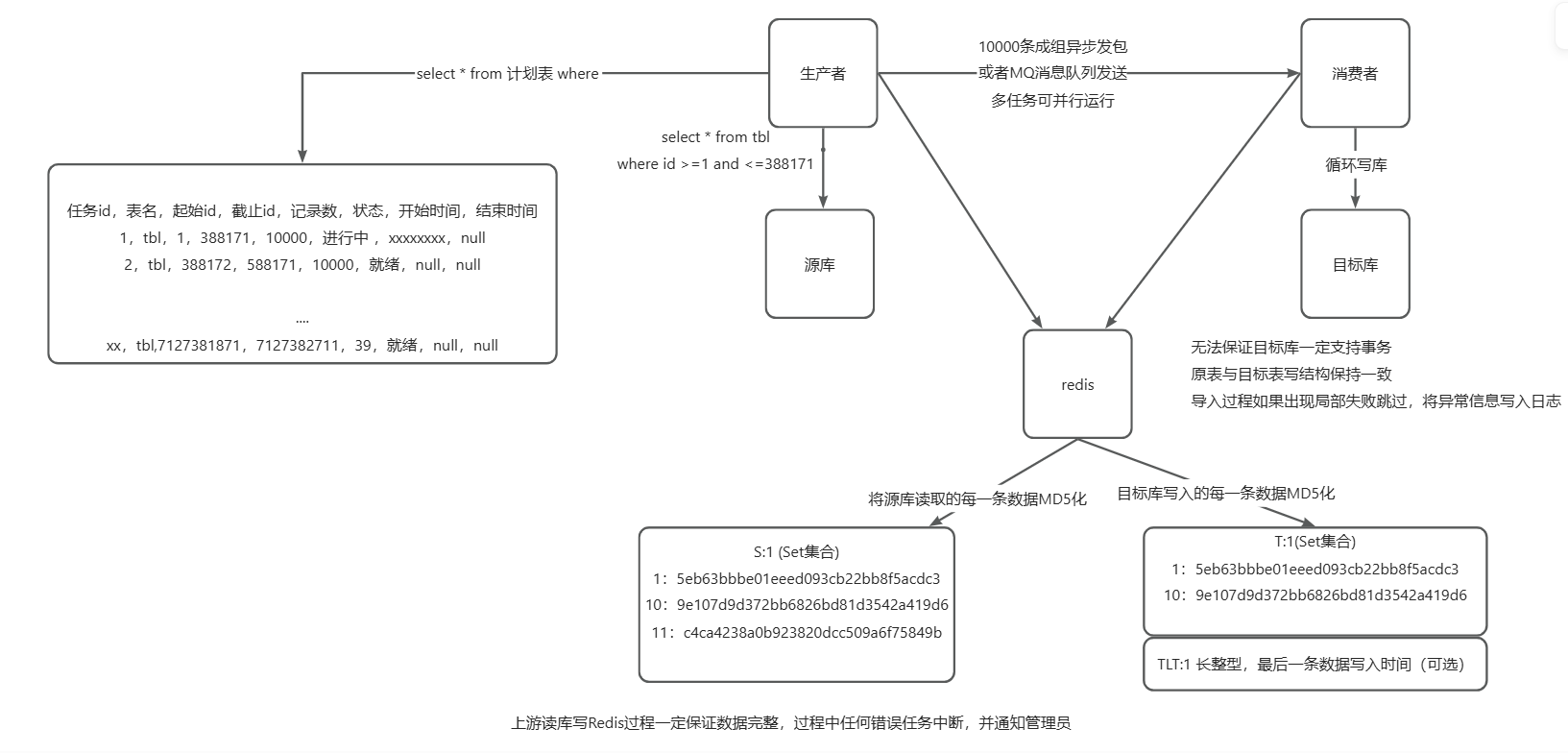

2.开始执行

key:source-表名-s0e1-state: pending|executing|finished

key:source-表名-s0e1-starttime:时间戳

key:source-表名-s0e1

0 1 2 3 4 5 6 7 8 9 10 11 …

0 1 1 0 0 1 0 0 0 1 0 0

target-表名-s0e1

0 1 2 3 4 5 6 7 8 9 10 11 …

0 1 1 0 0 1 0 0 0 0 0 0

10亿个数据,每条数据占用1位,需要大约119.21MB * 2。

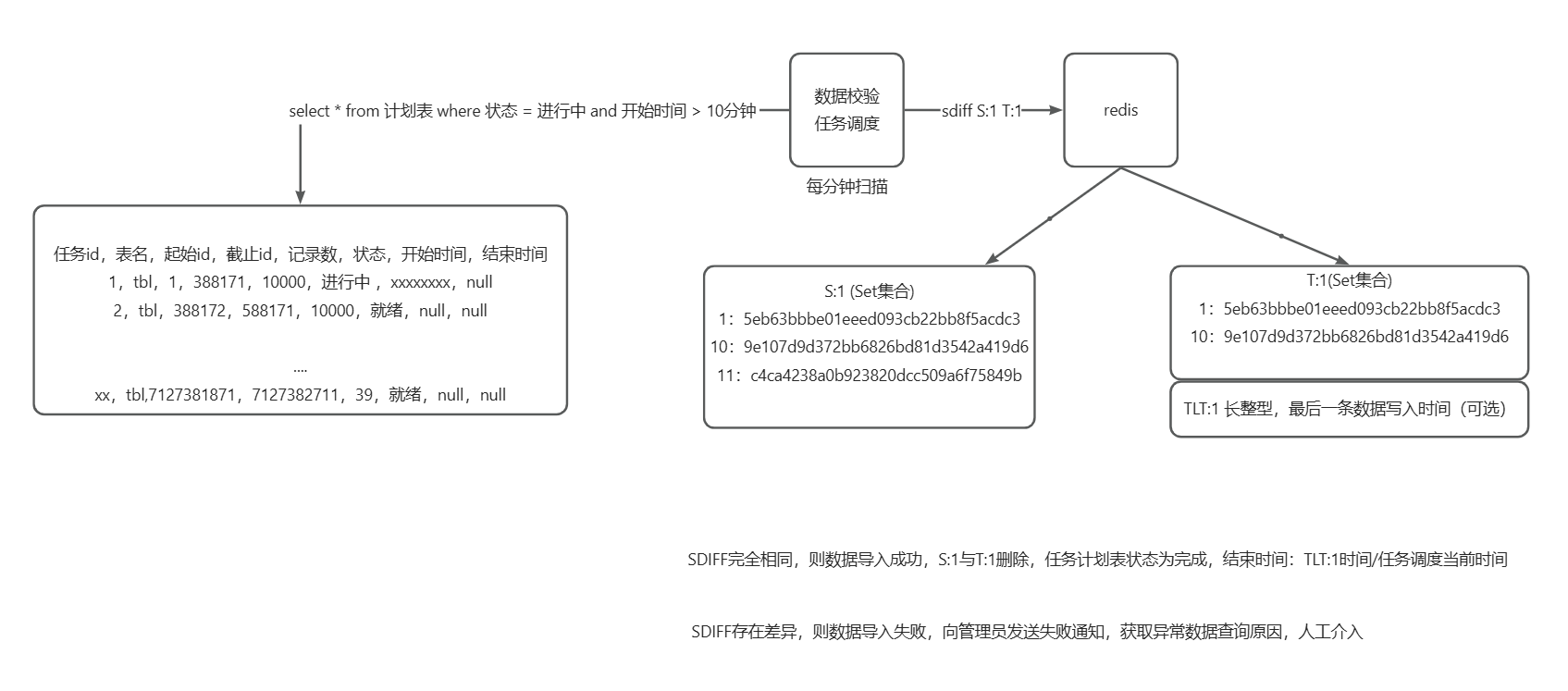

3.任务调度扫描

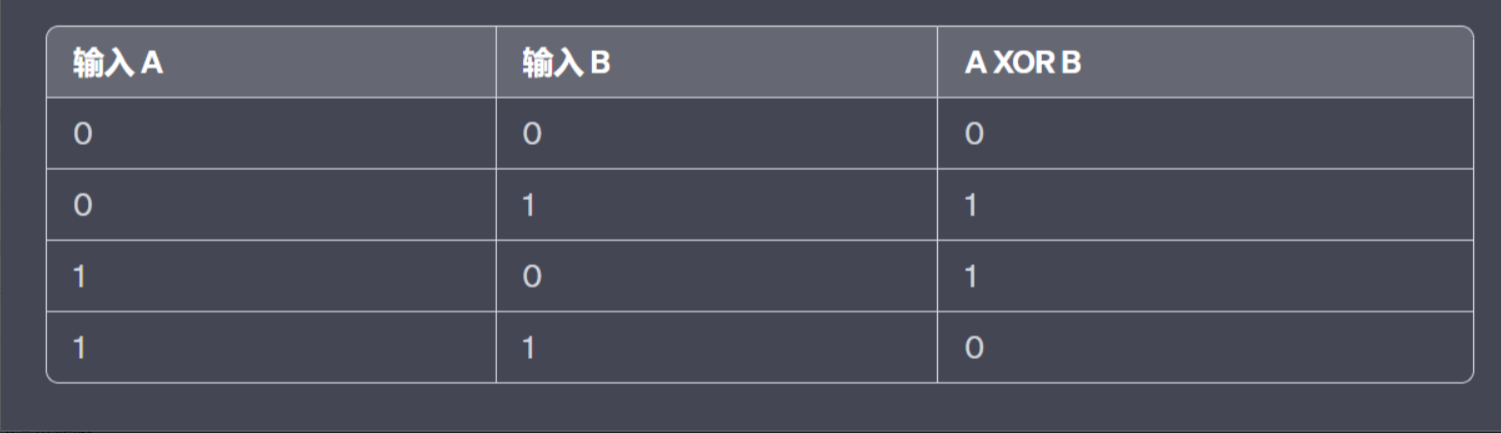

任务调度每n分钟扫描一次Redis所有finished标记状态:执行异或操作

“source-表名-s0e1” XOR “target-表名-s0e1”

0 1 2 3 4 5 6 7 8 9 10 11 …

0 0 0 0 0 0 0 0 0 1 0 0

生成结果

0+9号id未同步完成

产生警报

“当前时间” - “source-表名-s0e1-starttime” > 1小时 后仍然异或存在差异,将结果发送到管理员邮箱,人工补录